Läser nu: Vilka AI scrapers är bäst 2025?

- 01

Vilka AI scrapers är bäst 2025?

Vilka AI scrapers är bäst 2025?

Jag har testat en hel del webbscraping genom åren men AI scrapers gör både jobbet och strukturerar datan bra för en LLM. De här är mina personliga favoriter när det gäller att låta AI sköta grovjobbet med att plocka hem data från webben.

Innehållsförteckning

Firecrawl gör webben LLM redo

Firecrawl är nästan lite magisk. Du väljer vilken domän eller url, den hämtar rubbet och förvandlar det till ren och snygg markdown. Den fixar dessutom alla de jobbiga bitarna bakom kulisserna, som proxies och anti bot system. Om du vill ha en tjänst som bara fungerar och är redo för AI projekt direkt, då är det här ett självklart val. Helt klart en av mina personliga favoriter. Prova att köra den mot N8N i olika automatiseringar 😉

ScrapeGraphAI skrapar smart

Det här är mer av en verktygslåda än en enskild scraper. Du får SmartScraper, SearchScraper och Markdownify, och det är precis lika nördigt som det låter. Men det funkar. Jag använder den när jag behöver bygga dataset lite snabbare eller när jag vill koppla ihop saker med LangChain. Den är kanske inte för alla, men för oss som gillar lite kontroll är den grym.

Crawl4AI är effektiv open source för de nördiga

Kort och gott: gratis, kraftfullt och helt utan API nycklar. Crawl4AI är perfekt för den som vill hacka runt lite själv och bygga sina egna lösningar. Den ger data i markdown, klarar parallell crawling och är dessutom riktigt resurssnål.

Octoparse är drag och släpp för vanliga dödliga

Här är användarvänlighet i fokus för de som inte bryr sig om vad ett API är. Du öppnar Octoparse, klickar runt och markerar delar på en webbsida, och vips så har du en fungerande scraper utan att skriva en rad kod. Den är perfekt för enklare projekt där du bara vill få ut data snabbt. AI:n som identifierar fält sparar dessutom massor av tid, och de färdiga mallarna är som fusk fast på ett bra sätt.

Browse.AI gör jobbet utan kod

Det här är nog det mest business vänliga verktyget på listan. Du kan skapa robotar på bara några minuter och det finns redan över 200 färdiga att välja mellan. Kopplingen till Google Sheets och Zapier gör att den passar perfekt för den som bara vill automatisera sitt flöde utan att tänka för mycket.

ScrapingBee tar sig förbi spärrarna

Den här gillar jag för att den känns som en liten data ninja. Den klarar sajter som försöker gömma sig bakom JavaScript, den byter proxies så att du inte blir blockad och du kan till och med ge den instruktioner på vanlig engelska. Jag använder den gärna när jag behöver lite mer avancerad kontroll men ändå vill hålla det smidigt.

Apify skalar upp på riktigt

Apify är för den som menar allvar. Här kan du bygga dina egna Actors, schemalägga projekt, lagra resultat och jobba i team. Jag gillar att det finns ett helt bibliotek av färdiga mallar, men också att det är flexibelt nog för större projekt. Om webbscraping för dig handlar om mer än bara lite snabb datainsamling, då är Apify nästan som en hel arbetsplattform. En plattform som jag kört under ca 9 år.

img2dataset brutal bildscraper

Img2dataset är ett verktyg för att samla in enorma bilddataset med extrem hastighet. Ge den en lista med bildadresser eller en källa med text och länkar, så tankar den ner, kontrollerar och formaterar bilderna för dina AI projekt projekt. En given scraper i min vertygslåda!

Varning bara, det här är en brutal scraper som kan belasta servrar rejält om den körs oförsiktigt. Använd med respekt, stryp hastigheten, lagra lokalt och följ både lag och sunt förnuft. När du behöver mycket bilddata snabbt är den däremot svårslagen.

https://github.com/rom1504/img2dataset

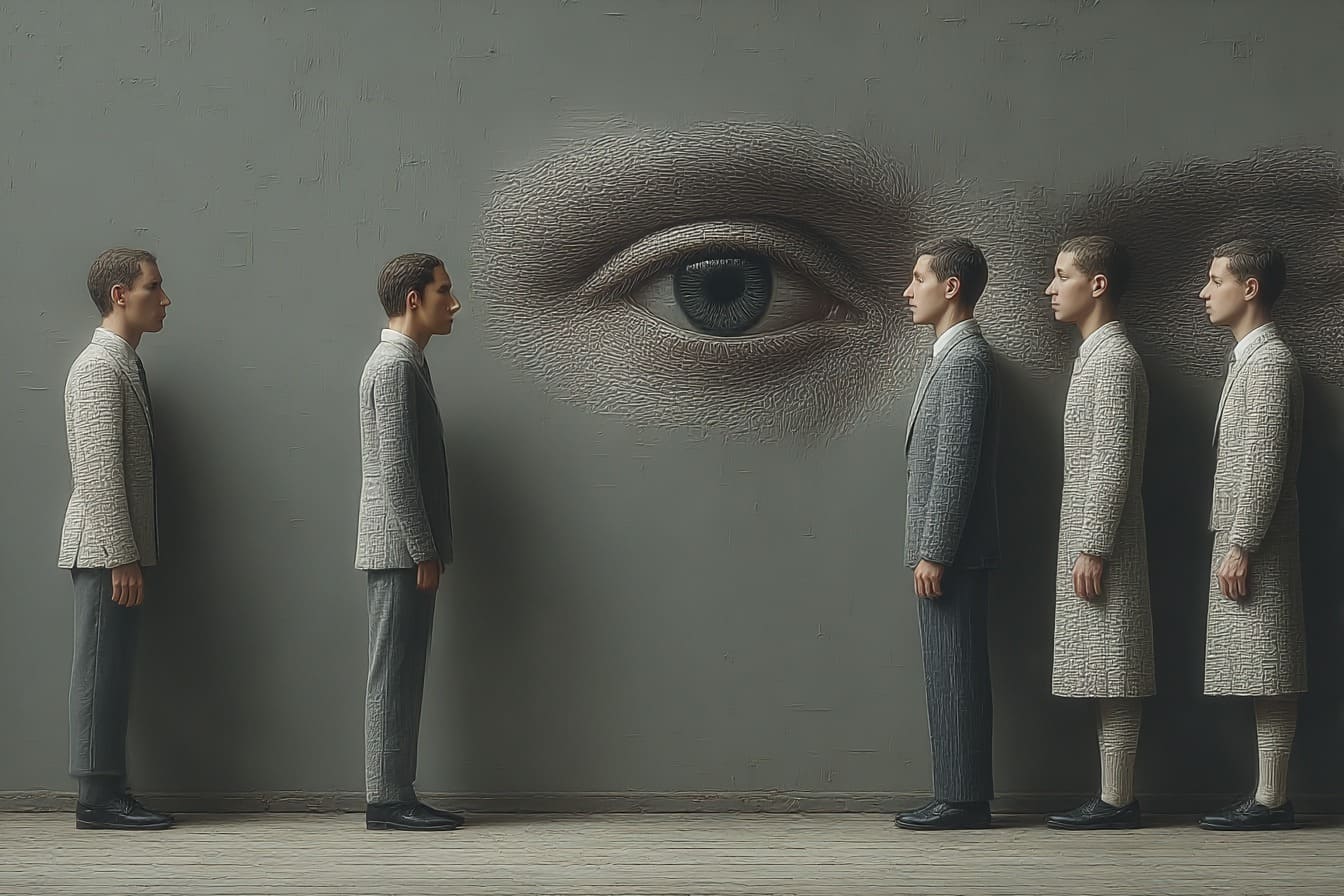

FAQ om etik och moral i webbscraping

Är webbscraping lagligt?

Nja, det beror på. Att hämta data som redan är offentligt tillgänglig är ofta okej, men vissa sajter har villkor (ToS) som förbjuder det. Och bryter du mot dem kan det bli problem, allt från sura mejl till advokater med riktiga fina slipsar.

Kan man scrapa vad som helst om man bara har tekniken?

Tekniskt sett ja. Moraliskt sett nej. Att hämta priser eller produktspecifikationer är en grej. Att suga åt sig personuppgifter, e postadresser eller innehåll bakom betalväggar är no no no.

Hur gör man för att scrapa schysst?

En tumregel: fråga dig själv om du hade blivit förbannad om någon skrapade din egen sajt på samma sätt. Om svaret är ja, då är du ute på hal is. Respektera robots.txt, belasta inte servrar i onödan och håll dig till data som faktiskt är menad att vara publik.